進階

Flux Depth Control

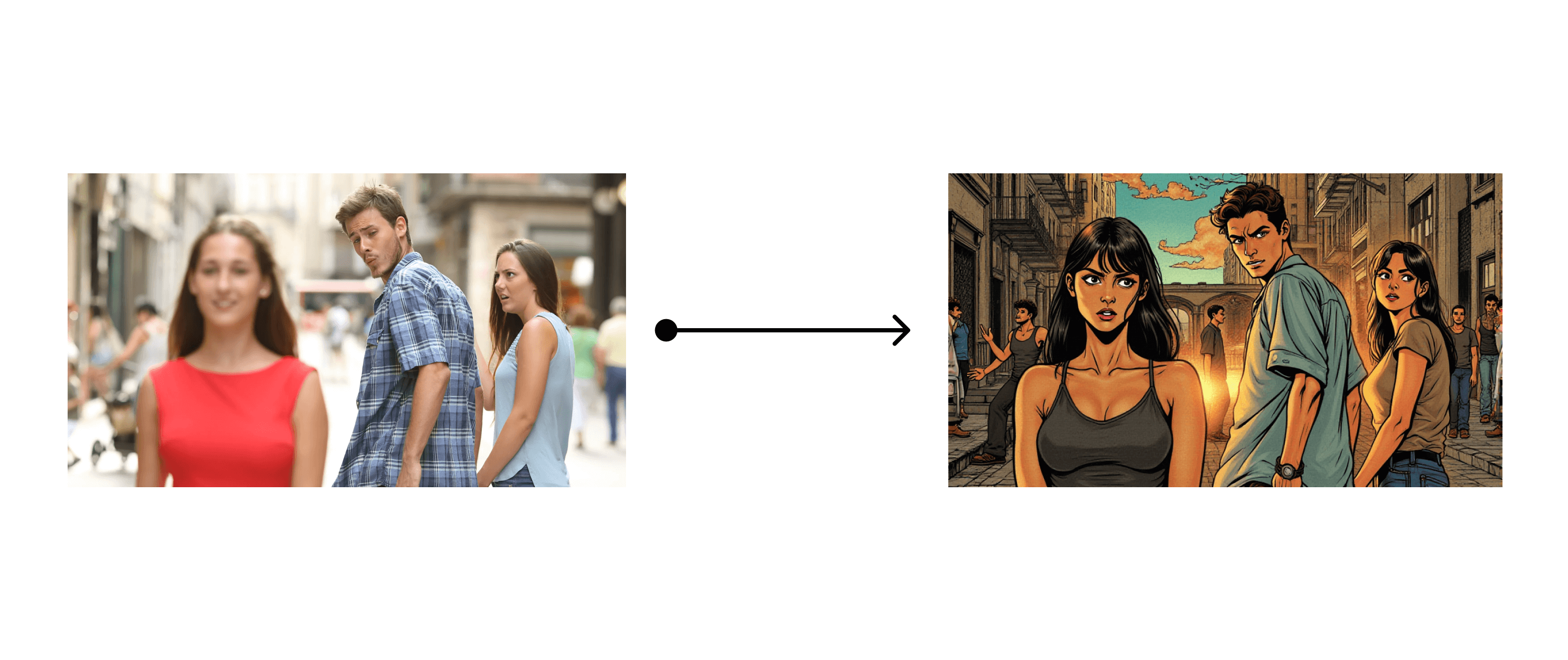

この章では、Flux Depth Control を使用して、元の画像と同様のコンテンツ位置深度を持つ画像を生成する方法を紹介します。

この画像は AI によって生成されました

1. Flux Depth モデルのダウンロード

Cannyと同様に、現在は2種類のFlux Depthモデルがあります。1つはFlux公式によるFlux Depth LoRAの実装で、もう1つは他のオープンソース組織によるFlux Depth Controlnetの実装です。前者はControl LoRA技術に基づいており、後者はControlNet技術に基づいています。 どちらもダウンロードして試してみることができます:- Flux公式は2つのDepth LoRAモデルファイルを提供しています。要件に応じて選択できます:

- 現在、Flux Depth Controlnetモデルを実装している2つのオープンソース組織があり、要件に応じて選択できます:

- 最初は、Shakker-LabsとInstantXが共同で開発したDepth ControlNetモデルです。このモデルをダウンロードし、

models/controlnet/フォルダに配置する必要があります。また、ダウンロード時にファイル名をinstantx_flux_depth.safetensorsに変更すると、その後の使用が容易になります。 - もう1つは、XLabsが開発したFlux Depth controlnet v2モデルです。このモデルもダウンロードし、

models/controlnet/フォルダに配置する必要があります。

- 最初は、Shakker-LabsとInstantXが共同で開発したDepth ControlNetモデルです。このモデルをダウンロードし、

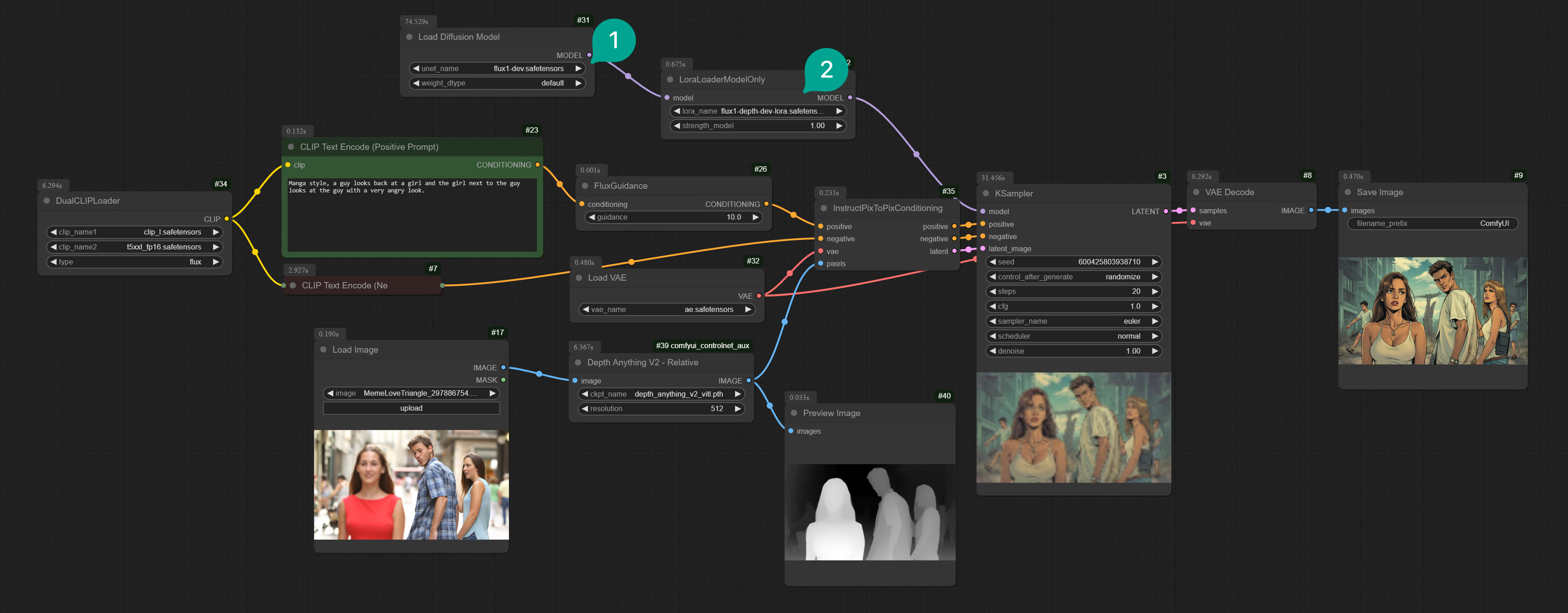

2. Flux Depth LoRA ワークフロー

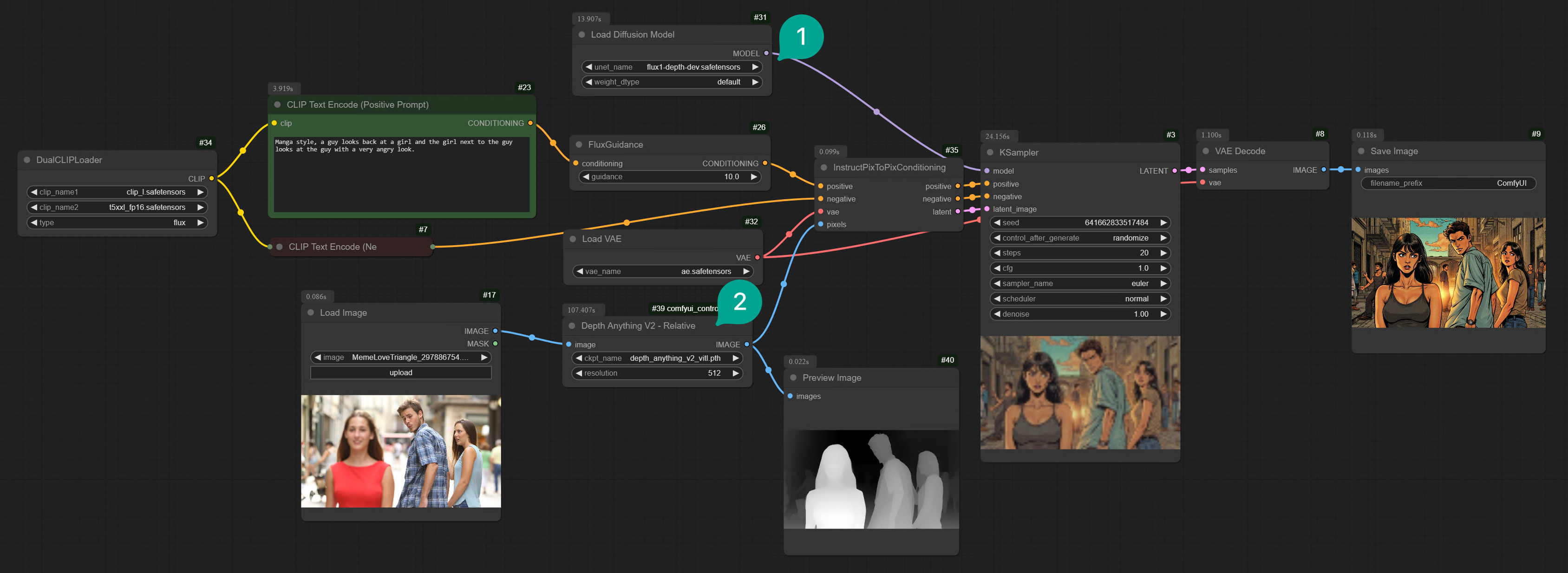

もし、モデルをダウンロードしたバージョンがLoRAとDevモデルを組み合わせたものであれば、前の章のFlux Edge Controlをベースにしてワークフローを修正するだけです。または、Comflowyからこのワークフローをダウンロードして使用します。 メソッドは非常に簡単です。① Diffusionノードグループ内のflux CannyをDepthモデルに置き換え、②Cannyノードを任意のDepthノード(お気に入りのDepthノードを使用できます)に置き換え、最後にDepthノードとLoad Imageノードを接続します。Depthノードの効果をプレビューしたい場合は、DepthノードとPreview Imageノードを接続して、Depthノードによって出力された深度マップを確認できます。

Load Diffusion Modelノード(図①)の後にLoraLoaderModelOnlyノード(図②)を追加するだけです。そして、Diffusionノードグループ内のflux dev depthモデルをflux devに置き換え、LoraLoaderModelOnlyノードでダウンロードしたFlux Depth LoRAモデルを選択します。

2つのバージョンの効果はほぼ同じです。

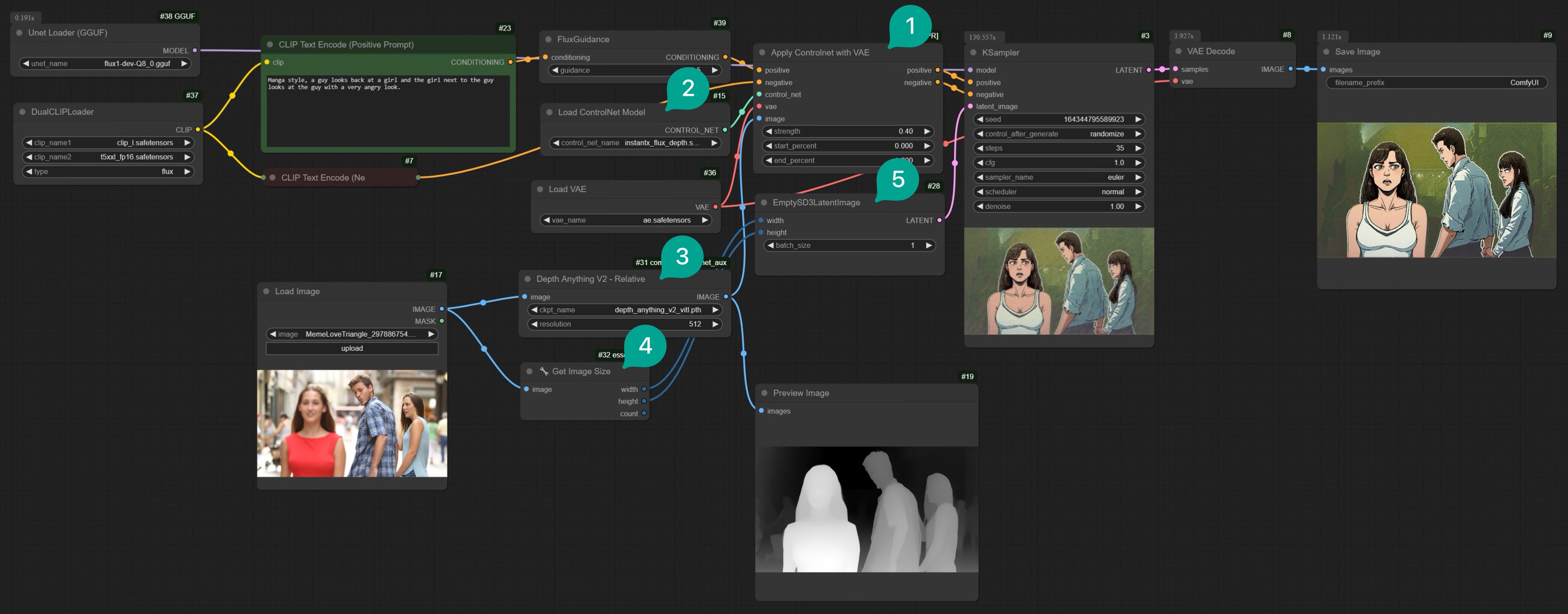

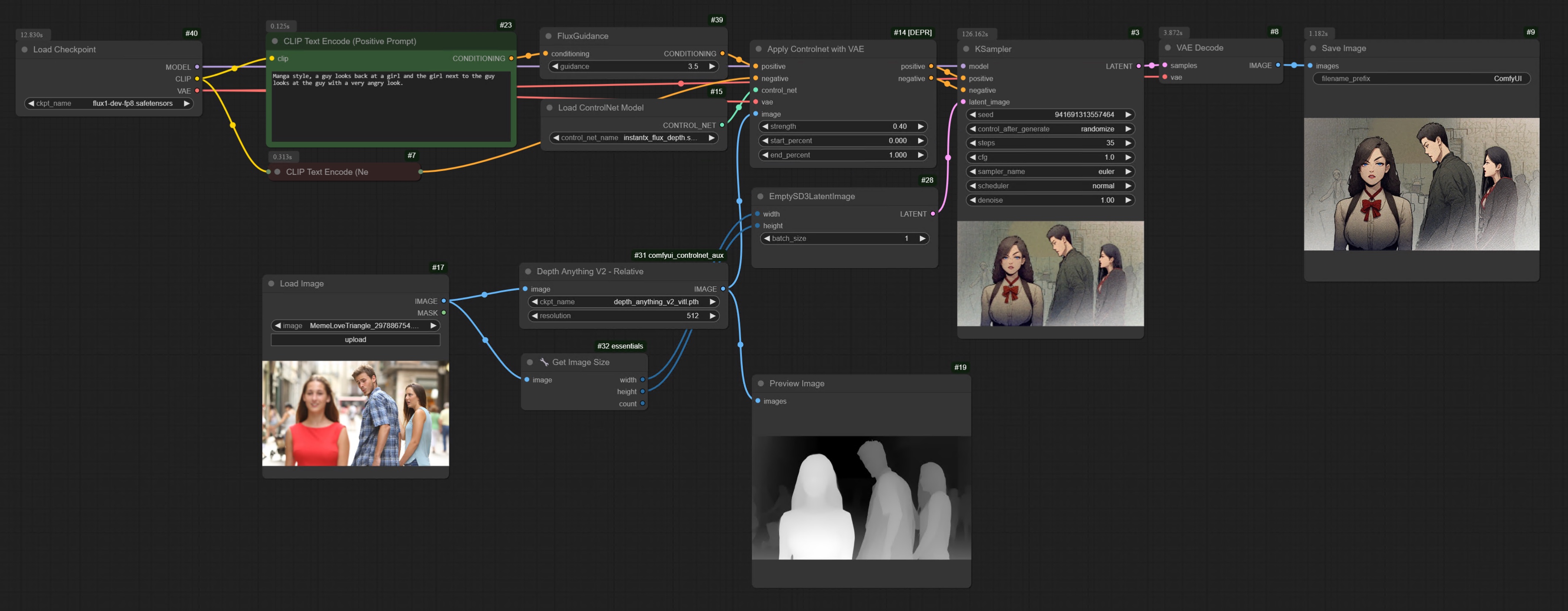

3. Flux Depth Controlnet ワークフロー

3.1 InstantX バージョン

まず、ControlNetモデルを実行すると余分なGPUメモリを占有するため、Flux ComfyUIワークフローでGGUFバージョンのFluxワークフローをロードし、それをベースにしてワークフローを修正します。または、Comflowyからこのワークフローをダウンロードして使用します。 このバージョンでは、以下の手順を実行します:Apply ControlNet with VAEノード(図①)を追加します。それをLoad VAE(図②)、Load ControlNet Model(図②)、および任意のDepthノード(図③)に接続します。Load ControlNet ModelノードでダウンロードしたFlux Depth Controlnetモデルを選択します。- 生成された画像のサイズが入力された深度マップのサイズと同じであることを確実にするため、

Get Image Sizeノード(図④)を追加し、それをSD3LatentImageノード(図⑤)に接続します。そのため、生成された画像のサイズは入力された深度マップのサイズと同じになります。

Load VAEノードとDualCLIPLoaderノードを削除し、Load Checkpointノードに置き換えるだけです。そして、FluxモデルのFP8バージョンを選択します。

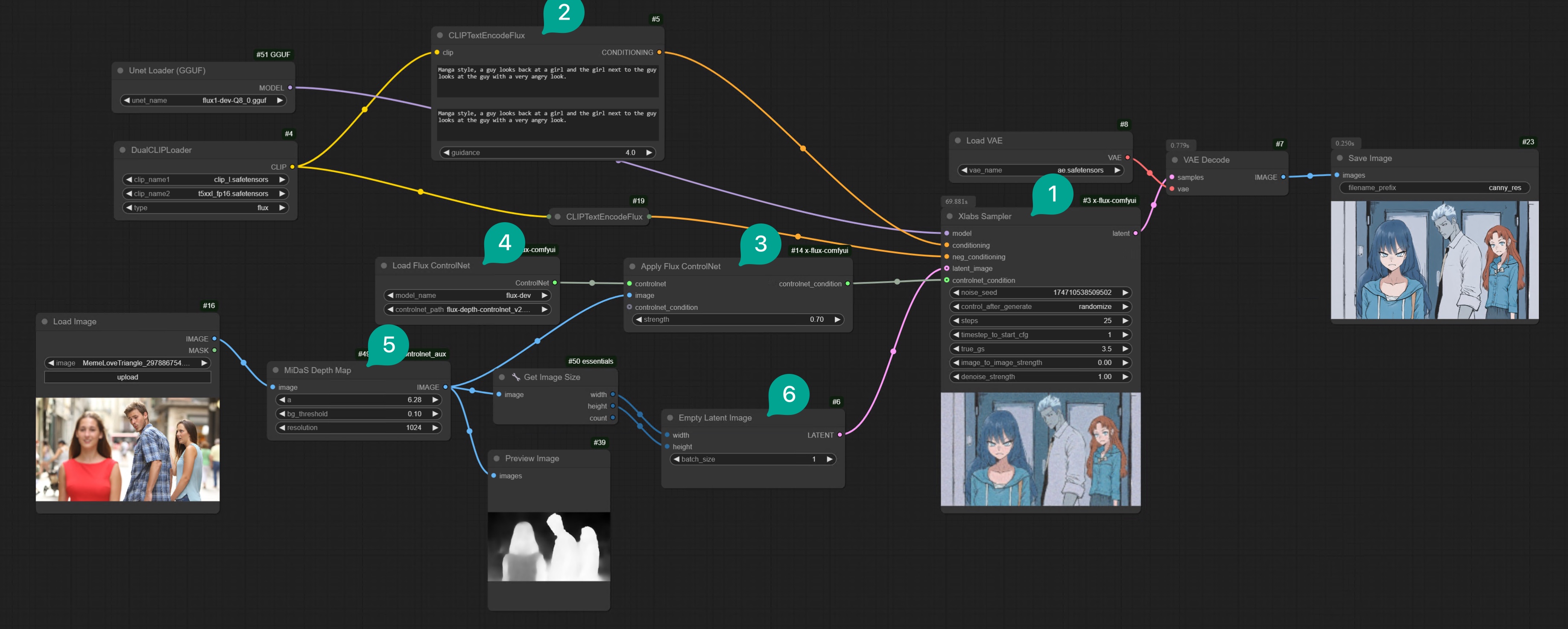

3.2 XLabs バージョン

XLabsバージョンのFlux Depth Controlnetモデルを使用するには、XLabsが開発したプラグインを使用する必要があります。そのGithubアドレスはこちらです。ComfyUIのComfyUI-Managerを通じてこのプラグインをインストールできます。詳細なインストール方法はComfyUIプラグインのインストールの記事を参照してください。 インストール後、Shakker-Labsバージョンのワークフローを修正できます。または、Comflowyからこのワークフローをダウンロードして使用します。 修正はそれほど難しくありません:| 図 | 説明 |

|---|---|

| ① | KSamplerノードをXlabs Samplerノードに置き換えます。このノードには追加のcontrolnet_condition入力があります。 |

| ② | CLIPTextEncodeノードをCLIPTextEncodeFluxノードに置き換えます。このノードには追加のcontrolnet_condition入力があります。 |

| ③ | Apply ControlNet VAEノードをApply Flux ControlNetノードに置き換えます。 |

| ④ | Load ControlNet ModelノードをLoad Flux ControlNetノードに置き換えます。そして、ダウンロードしたFlux Depth Controlnetモデルを選択します。 |

| ⑤ | Depthノードを追加します。お気に入りのDepthノードを使用できます。 |

| ⑥ | SD3LatentImageノードを使用します。これは、SD3バージョン以外にも最も基本的なバージョンで使用できることを示すためです。 |

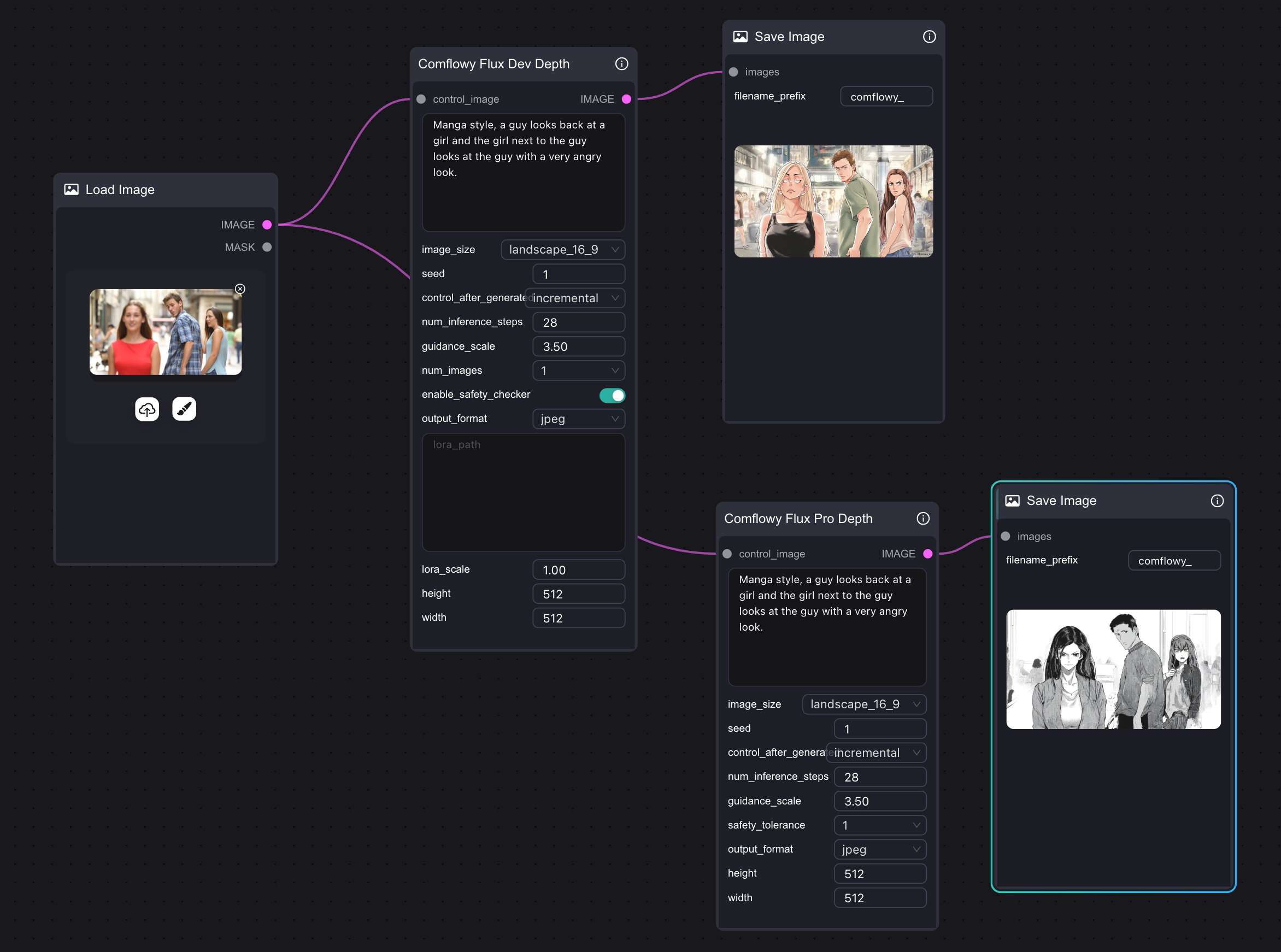

4. Flux Depth API ワークフロー

もしコンピューターの性能が十分でなく、Flux Depth モデルを実行できない場合は、ComfyUI で Comflowy の Depth API ノード を使用してみることもできます。もちろん、Comflowy で直接 Flux Depth API ノードを使用することもでき、リンク方法は非常に簡単で、1つのノードを使用するだけです。また、Flux Pro バージョンと Dev バージョンもサポートしています。注意,このノードはAPIを使用するため、使用時に相応の料金がかかります。